Первое рэп-видео на основе технологии deepfake для Lil Uzi Vert делали люди из России. Мы поговорили с ними

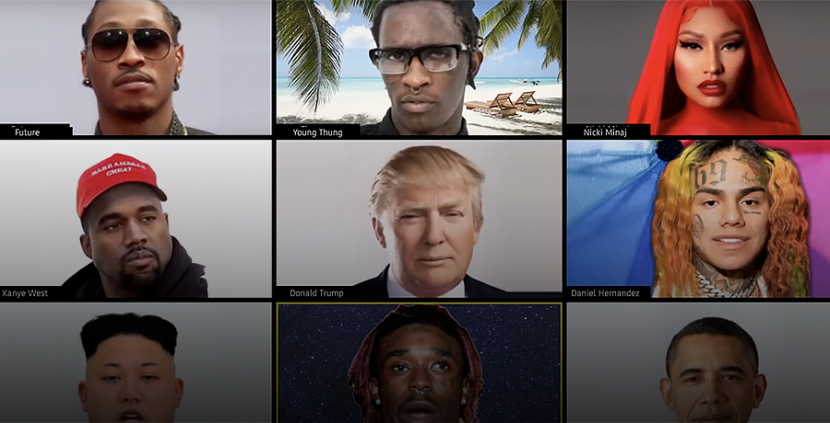

20 мая на Youtube появилось видео Lil Uzi Vert и Future “Wassup”. В нем столько знаменитостей, что их никогда не удалось бы собрать на одной съемочной площадке. Клип сделан на основе технологии deepfake, за которую отвечала компания Big Dada, собравшая интернациональную команду разработчиков. В их числе — два специалиста из России Карим Искаков и Али Алиев.

Мы узнали у Карима Искакова, как это работает, какая польза от deepfake помимо порно со знаменитостями и скоро ли эту технологию захотят запретить.

— Чем ты занимаешься?

— Я из небольшого города Кисловодска. Отучился в Московском физико-техническом институте, сейчас в аспирантуре в Сколтехе. Увлекаться искусственным интеллектом и компьютерным зрением я начал с третьего курса. Поработал в разных компаниях: Яндексе, небольших стартапах, сейчас — в одной большой компании.

Я всегда хотел найти способ применить ИИ в искусстве. Самый яркий пример такого синтеза за последний год, это нейронная сеть, которая умеет генерировать лица несуществующих людей. Неподготовленный человек не отличит их от настоящих.

Я делал две выставки с работами, которые публикую у себя в телеграм-канале. Но и канал, и выставки нацелены, в первую очередь, на более техническую аудиторию. Тем, кто не в теме ИИ, это не особо интересно. Да, картинки красивые, но прочувствовать весь кайф будет сложновато. А хотелось создать такое, чтобы это увидели и поняли многие.

Тут наступил карантин. Появилось свободное время, мир немного остановился, чтобы подумать. И мой друг Али Алиев буквально за несколько часов делает прототип приложения под названием Avatarify. Ты мог видеть видео, где фейковый Илон Маск подключается к зуму двух чуваков. Так вот, один из этих чуваков — это я. А Илон Маск на этом видео — это Али. У этого видео больше 150 тысяч просмотров.

Настоящему Маску мы писали в твиттере: “Илон, мы можем с твоим лицом заходить в зум. Давай ты к нам подключишься и мы сравним качество 1 к 1”. К сожалению, он не ответил, но наше приложение получило неплохой охват в прессе.

Что оно делает: ты можешь подключиться в зум, скайп, куда угодно в виде аватара любого человека. Достаточно добавить его фотографию, как мы это сделали с Илоном Маском. Звучит устрашающе, но при этом суперфаново, многие пользуются. Единственное ограничение состоит в том, что нужен мощный игровой ПК: нейронным сетям для создания “аватара” в реальном времени нужна хорошая видеокарта.

Avatarify — проект с полностью открытым кодом. Нейронную сеть мы сами не разрабатывали. Взяли ее у наших научных коллег, сделали над ней свою обертку, и получился классный проект, который сейчас хорошо развивается.

— Как попал в проект с Lil Uzi Vert?

— Пишет нам Билл Постерс. Говорит: “Чуваки, я увидел ваше видео с Илоном Маском. Мы сейчас делаем проект для Lil Uzi Vert. Не хотите ворваться и сделать для нас то же самое?” Билл, как оказалось, отвечал в этом клипе за технологию генерации дипфейков.

Там нет ни одного реального лица, кроме той девушки, которая позирует на кровати. Кстати, небольшой инсайд: у этой девушки в конце должно было оказаться лицо Uzi, но из финальной версии это почему-то вырезали.

Поскольку мы с Али любим искусственный интеллект и любим рэп, мы подумали, что это идеальное сочетание.

Мы удивились тому, как быстро они работают. Нам сразу сказали: “Планируем закончить весь проект за две недели”. Так примерно и получилось.

Чтобы анимировать звезду, как это сделано в клипе, нужна ее фотография. Лицо человека должно быть посередине кадра и смотреть в объектив. И нужен другой человек, который наложит ее изображение на свое и просто будет открывать рот в такт музыке. Получается такой lipsync.

Ребята составили список из более чем 70 звезд, которых хотят видеть в клипе. Сделали раскадровки по строчкам текста и отправили все это нам. Мы что-то подкорректировали, говорили, как лучше снимать видео, но в итоге нам самим тоже пришлось снимать lipsync-видео. Мы ставили телефон, включали трек и зачитывали текст строчка за строчкой. Чувствовали себя тик-токерами. Под конец было много правок типа: “Мы хотим добавить всю семью Кардашьян” или “В клипе мало женщин, надо еще”. Ну и мы генерировали новые видео.

— Lil Uzi Vert подключался?

— Не знаю. Мы общались через режиссера Яшу Грубина. Он довольно известный чувак, уже делавший клипы для Uzi, Gucci Mane и Wiz Khalifa. Обсуждали проект с ним и с чуваком, который изначально с нами связался.

Когда идет работа для звезды такой величины, ей, как я понимаю, показывают только начальную версию и уже финальный результат.

— Когда стал слушать рэп?

— Со школы, класса с девятого. Наверное, как у многих, увлечение русским рэпом началось с группы Centr. Подъездный рэпчик, но почему-то торкнул. Рэп на английском языке я начал слушать с Kanye West. Потом — Kendrick Lamar, Drake и другие. Из рэпа я не уходил, постоянно его слушал. Ни EDM, ни рок не смогли меня увлечь. Из наших исполнителей для меня еще с 2015-го самый топ — это Скриптонит.

Любимые альбомы 2020-го — это Mac Miller “Circles” и 104 “Кино без сигарет”. Еще долго ждал альбом Pharaoh, но он сильно разочаровал. Надеюсь, Boulevard Depo с предстоящим релизом не подведет.

— Вам заплатили за клип?

— Видео было благотворительным, этот вопрос с нами обговорили изначально. Мы сказали, что нам интересно не из-за денег, плюс мы разрабатываем открытый софт, то есть наше приложение Avatarify, которое мы использовали в клипе и нейронная сеть, на которой мы основывались, работают под некоммерческой лицензией. Все ребята, которые работали над клипом, работали бесплатно. Бюджет пошел на помощь людям, которые помогали стабилизировать ситуацию с COVID-19 в Нью-Йорке.

— Знаменитости, чьи изображения использованы в “Wassup” могут подать на вас в суд?

— Юридическая база для этого еще ни в одной стране не готова. Мы заанимировали фотографию человека при помощи нейронной сети. Непонятно, может ли он подать на нас в суд, если бы мы использовали его изображение и вложили ему в уста какие-то плохие заявления. В США сейчас есть законы, которые обязывают медиаресурсы указывать, если в материалах используются технологии Deepfake. Так уже сделано в твиттере. Можно вспомнить клип Kanye “Famous”, в котором в одной кровати с ним лежали Дональд Трамп, Эмбер Роуз и другие. Я не уверен, как они это сделали — то ли актеров похожих нанимали, то ли кукл реалистичных изготовили. Им вроде за это не прилетело, клип и сейчас доступен на Youtube.

Часто спрашивают: “А вы не думаете, что такую технологию могут применить в каких-то плохих целях?” Мы, конечно, понимаем, что это может произойти, но, все-таки, прогресс не остановишь, и качество этих дипфейк-видео будет только расти. Это сложно регулировать при помощи закона, это должно быть отрегулировано самим обществом. Наступит момент, когда технология демократизируется и люди поймут, что такое видео сгенерировать просто, как в свое время это произошло с фотошопом. Сейчас любой чайник при помощи уроков на ютубе сможет зафейкать, как играет в баскетбол с Джорданом, но никто ему не поверит, потому что все понимают, что фотошоп существует, и при его помощи можно сделать реалистичный фотомонтаж задешево. Здесь будет то же самое, просто люди будут знать, что не всем видео теперь можно верить, ведь зафейкать их стало проще.

— Простыми словами: что такое Deepfake?

— Тема с фейками имеет очень долгую историю. Изначально люди фейкали письма и отправляли их от чужого имени. Фейкали фотографии в том же фотошопе. Сейчас вот научились фейкать видео. Природа фейка существовала всегда, просто появляются новые модальности. Изначально — текст, потом фотография, сейчас видео. Скоро появится и звук, можно будет фейкать голос. К этому нужно относиться как к неизбежному прогрессу. Это точно будет происходить.

Deepfake – это фейк созданный с помощью глубинной (поэтому deep) нейронной сети. Это может быть перенос лица одного человека на другого (face swap) или анимирование статической фотографии, как мы делали для клипа Uzi.

Deepfake для переноса лиц (face swap) — это тот, о котором все узнали несколько лет назад. Когда люди вставляли в порно лица других известных личностей. Есть два параллельных видео: на одном пусть будет порно, а на втором — источник со знаменитостью, на чье лицо ты хочешь заменить лицо актрисы из первого ролика.

Нейронная сеть, отсматривая эти видео и анализируя то, как эти лица двигаются и какими характерными особенностями обладают, пытается перенести одно лицо на другое. Причем там все так хитро сделано, что нейронная сеть штрафует саму себя. Она пытается перенести лицо, и если сама видит, что этот перенос плохой, она пытается так подстроить свои параметры, чтобы переделать и перенести его лучше. Это такая игра в полицейского и фальшивомонетчика, где сеть-фальшивомонетчик пытается сгенерировать несуществующее изображение (фальшивые деньги), а сеть-полицейский пытается понять, настоящее это изображение или сгенерированное (настоящие деньги или фальшивки). Такая игра между генератором и, так называемым, дискриминатором в результате приводит к тому, что генератор начинает генерировать реалистичные изображения, которые сложно отличить от настоящих.

В команде помимо Карима Искакова, Али Алиева и Билла Постерса был новозеландец Джефф Уайт, который ведет в инстаграме аккаунт Dr. Fakenstein вот с такими дипфейками

В клипе Lil Uzi Vert мы использовали другой метод, который позволяет анимировать чужие лица с помощью всего лишь одной фотографии. Для этого достаточно взять фото Cardi B или Nicki Minaj из интернета, параллельного видео, как для классического deepfake, уже не требуется. Только фото и человек, который своей мимикой будет двигать изображение знаменитости. Вместе с Биллом Постерсом, который к нам обратился, мы нашли хорошие фотографии звезд — их было больше 70 — по одной фотографии на звезду.

В классическом deepfake’е генерация видео может занимать больше суток. Там на вход подаются два видео, но твоя нейронная сеть должна сперва обучиться делать face swap. Обучение — это трудоемкий процесс, загружающий видеокарту на 100%, вентиляторы будут дико шуметь, нужен мощный игровой ПК. А в том методе, который использовали мы, можно генерировать видео со звездой в реальном времени. Добавил фотку — и можно анимировать.Такой подход более юзабелен.

— Существует ли способ отличить Deepfake-видео от реального?

— В научном сообществе существует этическая дилемма: “Мы придумали, как это реалистично генерировать. Теперь надо придумать технологии, чтобы отличать фейки от реальных видео и не позволять использовать их в плохих целях”. Об этом уже написано много научных статей.

Люди уже научились отличать дипфейки с помощью алгоритмов, но каждые полгода, алгоритмы меняются, появляется что-то новое, требующее новых методов выявление фейков. Такая гонка, как между теми, кто создает вирусы, и теми, кто создает антивирусы.

Раньше одним из самых работающих способов отличить реальное видео от дипфейка было моргание. В старых алгоритмах дипфейки плохо моргали по техническим причинам, но в нашем видео для Uzi такой способ уже не прокатит. Я верю, что в будущем появится метод, который будет отличать почти все дипфейки и не будет проблем.

— Как к этому относятся Google и Facebook?

— Недавно Facebook проводил соревнование с призовым фондом в миллион долларов, где разработчикам нужно было придумать алгоритм, как отличать дипфейки от обычных видео.

Facebook сильно обеспокоился своей безопасностью и распространением фейк-ньюз, особенно в свете серьезной взбучки с утечкой данных Кембридж-аналитики и того, что русские хакеры могли использовать соцсеть для влияния на исход выборов в США.

— Какую пользу Deepfake может принести человечеству?

— В первую очередь, это фан. Но есть и перспектива для объективной пользы.

Скажем, я могу задипфейкать самого себя. Представь, что сейчас с тобой говорю не я, а моя сгенерированная проекция, а я лежу в кровати, небритый и непричесанный. То есть дипфейк способен изменить то, как мы используем видеозвонки. Ты хорошо меня видишь, видишь мои эмоции, но я хочу сохранить свое privacy, потому что лежу на диване в неприглядном виде.

Либо я, например, общаюсь с психотерапевтом по зуму и не хочу показывать свое лицо. Я могу взять сгенерированное с помощью нейронной сети лицо и быть этим несуществующим человеком.

А если говорить про более технические вещи в области видеосвязи, то возьми лагающую видеосвязь при плохом интернете. Это происходит потому что один абонент передает другому свое видео, а видео — довольно тяжелый кусок информации, который сложно передавать по медленному интернету. В случае технологии, которая в используется в Avatarify, можно сделать следующее: ты мне будешь передавать не все свое видео, а просто перешлешь свою фотографию один раз. А далее будешь посылать уже не видео, а свое выражение лица, координаты мимики. Такая информация очень компактная, она гораздо легче, чем видео. По идее это способно совершить революцию в видеосвязи и позволить бесперебойно ею пользоваться даже при очень слабом соединении.

Плюс виртуальные ассистенты. Если Яндекс захочет, чтоб у Алисы было лицо, это можно будет сделать. В будущем, наверное, не будет кассиров, но если тебе захочется человеческого общения, ты можешь пообщаться с компьютером — и будет круто, если у него будет реалистичное человеческое лицо. Способов применения очень много — и они не только плохие.

— Твой топ-3 дипфейк-роликов.

— Самое любимое — это где Илон Маск как ребенок.

Второе — очень смешное видео с Николасом Кейджем, где он в образе Эми Адамс.

А чтобы был не только фан, вот видео с Дэвидом Бэкхемом. Он участвовал в кампании против малярии и говорил в видео на 9 языках. И что чуваки сделали: они записали один раз, как Бэкхем говорит на английском, и с помощью deepfake-технологии смогли так подрисовать его губы, чтобы они двигались в такт звуку. Это тоже один из способов применения технологии.